Las autoridades españolas de prohíben a Worldcoin que recoja los datos del iris y se abre el debate de si cuidar la privacidad es una responsabilidad individual o colectiva

La Agencia Española de Protección de Datos (AEPD) ha tomado este miércoles una decisión inédita. Durante los próximos tres meses, no podrán seguir operando los orbes de Worldcoin, que desde julio han escaneado el iris de unos 400.000 españoles para validar sus cuentas y los recompensan con un lote de criptodivisas, que ahora tienen un valor de unos 80 euros. Los datos recogidos hasta la fecha por Worldcoin, empresa vinculada a Sam Altman, el padrino de ChatGPT, quedan bloqueados, por lo que no se podrán tratar ni compartir hasta que una investigación internacional dirima si es legal o no que una empresa privada recoja ese tipo de datos.

Es la primera vez que la AEPD toma medidas cautelares. La directora de la agencia, Mar España, ha subrayado su carácter excepcional: “Hemos actuado con urgencia porque así lo requería la situación. Nuestra decisión está justificada para evitar daños potencialmente irreparables. No tomarla habría privado a la gente de la protección a la que tiene derecho”.

¿Por qué esta repentina celeridad en paralizar la recogida de fotografías de alta resolución del iris de los usuarios? “Porque se ha generado un estado de alarma social. Creo que las colas que se han formado en los centros comerciales y el hecho de que haya criptomonedas de por medio han obligado a la AEPD a moverse rápido”, opina Borja Adsuara, consultor y experto en derecho digital, que expresa su preocupación por que “no se ponga el foco en lo importante: el problema no es que te den dinero por tu iris, sino si ese dato se está tratando de forma correcta”.

El valor de los datos biométricos

Hay muchos tipos de datos personales. Los más usados en los trámites del día a día son nombre y apellidos, domicilio o número de teléfono. Todos ellos pueden servir para identificar a un individuo concreto, pero comparten otra característica: el interesado los puede modificar.

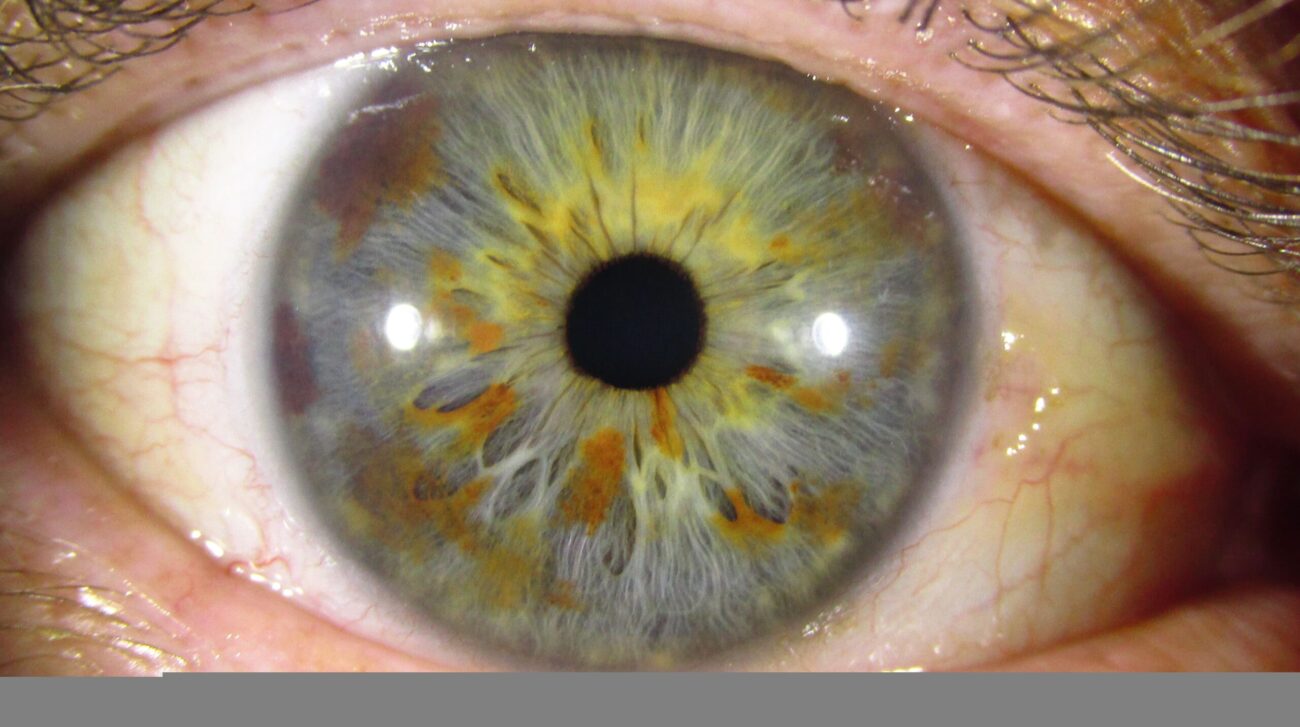

Otros datos personales, sin embargo, nos acompañan de por vida. Son los llamados datos biométricos: los que aluden a características únicas de cada persona, ya sean fisiológicas, físicas o relativas al comportamiento. Este tipo de información se puede codificar y a menudo permanece inmutable con el paso del tiempo. Tenemos el mismo ADN desde que nacemos hasta que morimos. Lo mismo pasa con las huellas dactilares (a menos que las quememos). El rostro evoluciona con los años (engordamos, envejecemos, perdemos pelo), pero hay algoritmos capaces de establecer patrones singulares —por ejemplo, midiendo la distancia entre los ojos, de estos con la nariz o la boca— que permiten reconocer a las personas con un alto nivel de acierto y de forma sostenida en el tiempo.

El iris es, de entre los distintos datos biométricos, el que identifica de forma más certera a una persona, según David Arroyo, investigador principal del grupo Ciberseguridad y Protección de la Privacidad del CSIC, quien advierte que “si te roban el iris, o, mejor dicho, la plantilla alfanumérica con la que se almacena ese rasgo biométrico puede suplantar tu identidad en muchos sitios. La lectura de iris es mucho más precisa que el reconocimiento facial. No se usa tanto porque el sensor necesario es más caro y el ajuste de estos sistemas más complejo”.

Además de su valor como identificador personal, un análisis del iris puede aportar mucha otra información, tanto fisiológica como de comportamiento. “A través de la mirada y de cómo dilata la pupila puedes saber qué es lo que le gusta a alguien, qué le asusta, qué le interesa y hasta ciertas características cognitivas, como si tiene párkinson”, indica Carissa Véliz, profesora de filosofía en la Universidad de Oxford y autora del libro Privacidad es poder.

La lectura de iris se suele circunscribir a entornos de alta seguridad, como un medio de identificación adicional para acceder a ciertas dependencias. “Permite hacer una autenticación muy robusta, pero entraña muchos problemas de privacidad, porque el iris es algo que está directa e inequívocamente vinculado a una persona en concreto”, apunta Arroyo.

Un tratamiento especial

Las particularidades de los datos biométricos hacen que su tratamiento legal sea más estricto que el resto. “La legislación europea los considera una categoría especial de datos. Se pueden captar o bien cuando la legislación española expresamente lo permita para ciertos supuestos, o cuando haya consentimiento”, argumenta Ricard Martínez, director de la cátedra de Privacidad y Transformación Digital de la Universitat de València. “La normativa española dice que, en datos de salud y biométricos, supuestamente, deberías poder consentir. Pero eso no significa que todo sea posible. Podrías contar con el consentimiento del afectado y perseguir una actividad ilícita o no proporcionada, o vulnerar un derecho fundamental. Es más complicado de lo que parece”.

El uso proporcionado de estos datos es clave. La AEPD multó en 2021 a Mercadona con 3,5 millones de euros (abonó 2,5 por acogerse al pago voluntario) por utilizar cámaras con sistemas de reconocimiento facial en 48 de sus tiendas. En este caso, sin el conocimiento ni el consentimiento de los clientes. La empresa argumentó que instaló esa tecnología para detectar a personas con orden de alejamiento de sus establecimientos. La agencia resolvió que el fin perseguido, identificar a personas condenadas, no justificaba recoger patrones faciales de todo aquel que entrara en los supermercados de la cadena.

Volviendo al caso de Worldcoin, los orbes escanean el iris y convierten esa imagen en un código alfanumérico. Esa plantilla es lo que identifica al usuario. “El problema no es que Worldcoin haya recogido este dato de 400.000 personas, sino que pongan todas esas bases de datos e imágenes a disposición de otros algoritmos y que no digan exactamente para qué”, dice Jorge García Herrero, delegado de protección de datos y abogado especialista en hacer cumplir esta normativa.

El gran peligro de los datos biométricos es que se usen con fines no legítimos. En China, por ejemplo, se emplean sistemas de reconocimiento facial para vigilar y perseguir a los uigures. Existe la sospecha de que, cuando en 2021 los talibanes recuperaron el control de Afganistán, recurrieron a tecnologías de identificación biométrica, como la lectura de iris, para detectar y reprimir a colaboradores con el antiguo régimen. La biometría es una herramienta inigualable si lo que se busca es reprimir y, por supuesto, los datos biométricos también pueden usarse para suplantar la identidad de las personas.

¿Y si no me importa la privacidad?

“Yo soy un ciudadano de a pie, Google ya tiene todos mis datos, no creo que el ojo aporte mucho”, decía hace dos semanas a Umbral.com.do un joven que se disponía a escanearse el iris en el centro comercial de La Vaguada, en Madrid. Es un argumento recurrente. Carissa Véliz, de la Universidad de Oxford, lo considera falaz. “Tendemos a pensar que cuando algo es personal es individual, pero cuando compartes tus datos personales, en realidad también estás poniendo en peligro a otros, como se vio en el caso de Cambridge Analytica”, explica en referencia al escándalo protagonizado por dicha consultora, que accedió a información personal de 50 millones de usuarios de Facebook para crear perfiles de votantes estadounidenses y dirigirles publicidad electoral personalizada.

“Puede que a ti no te importe tu privacidad, pero es que yo no la veo como un derecho, sino como una obligación, porque puedes poner en riesgo a todo tu entorno”, esgrime por su parte David Arroyo, del CSIC. “Ese tipo de datos se utilizan luego para caracterizar a otras personas, y con ellas se montan ataques más sofisticados, como de phishing o desinformación”, apunta. Aunque se ejerza luego el derecho a rectificar y se borren los datos biométricos recogidos, ya se habrán utilizado para entrenar la herramienta, es decir, para hacerla más eficiente.

Lo que preocupa a los expertos del caso Worldcoin es que contribuya a que se normalice una tecnología, la lectura de iris, que tiene doble filo. “Si dejamos que se establezca como un modo legítimo de verificación, al final todo el mundo acabará usándolo”, dice Véliz. “Me ha molestado mucho que se normalice el uso del reconocimiento facial para desbloquear los teléfonos. Creo que ha hecho que la gente perciba esa tecnología como algo natural. Confiemos en que no pase lo mismo con la lectura de iris”